Claude Shannon: pai da Teoria da Informação nascia há 97 anos

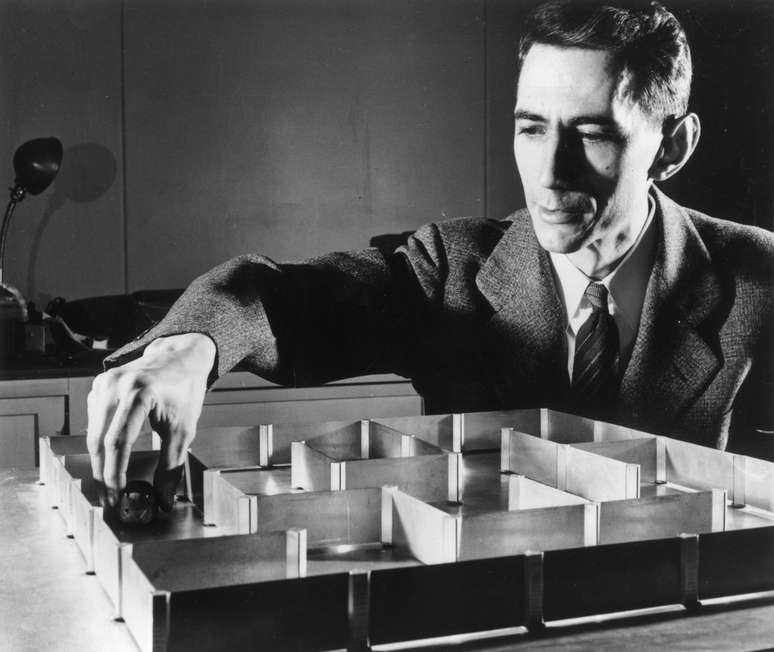

Considerado o pai fundador da era de comunicação eletrônica, Claude Shannon foi um engenheiro matemático cujo trabalho em problemas técnicos da comunicação lançou as bases tanto para a indústria de computadores quanto para as telecomunicações. Enquanto trabalhava no laboratório criado por Graham Bell, em 1942, o americano formulou uma teoria explicando a comunicação das informações e contribuiu para o estudo do problema sobre como transmitir informação de maneira mais eficiente.

A batalha dos cientistas: qual foi o maior gênio da humanidade?

A teoria matemática da comunicação feita em conjunto com o matemático Warren Weaver foi o ponto alto das investigações científicas de Shannon. O conceito de entropia transposto para a comunicação também foi um importante aspecto da teoria - ele demonstrou que a entropia da informação era equivalente à falta de conteúdo informativo, um grau de incerteza em uma mensagem.

Claude Elwood Shannon nasceu em 30 de abril de 1916 na pequena cidade de Gaylord, Michigan. Estudou engenharia elétrica e matemática no Instituto de Tecnologia de Massachusetts, onde concluiu seu mestrado e doutorado em 1940. Apaixonado por música, tinha cinco pianos e 30 outros instrumentos em casa, de flautins a trompetes. Inventor nato, contava com uma máquina de jogar xadrez, um monociclo com uma roda descentralizada e outros inventos.

Shannon trabalhou para a Bell Telephone Laboratories como matemático pesquisador a partir de 1941. Ali, se dedicou a aprimorar a qualidade da transmissão de informações. Em 1948, conseguiu explicar o problema fundamental da comunicação de maneira quantitativa: a unidade básica de informação é uma situação de "sim-não". Ou algo é ou não é. Isso pode ser expressado através da álgebra binária booleana por meio dos números 1 e 0, onde 1 significa "sim" (ou ligado) e 0 significa "não" (ou desligado). Esse é hoje o "sistema nervoso" de cada computador no mundo.

-10-28-18_b5874967-1jeo9lksincxd.jpg)

-s163vxzsn8ti.png)

-15-31-36_f0243001-1hvb0lof4eiwl.jpg)