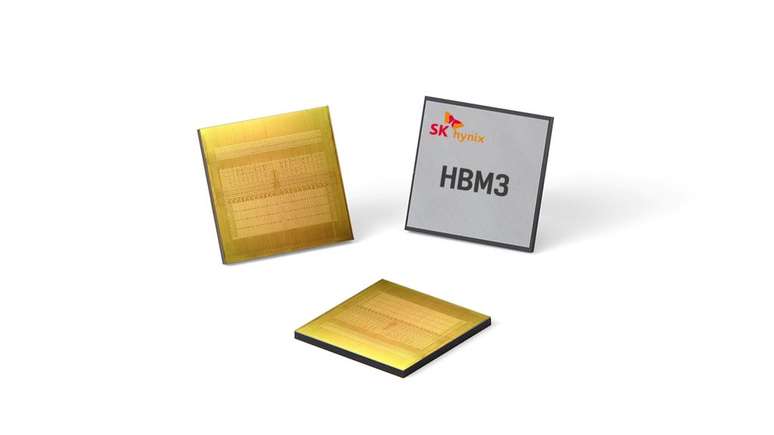

Memórias HBM4 devem trazer largura de banda duas vezes maior

Memórias HBM4 em desenvolvimento pela Samsung e SK Hynix teriam barramento de 2048-bits e dobro da largura de banda das HBM3, revolucionando HPC e GPUs para IA

As novas memórias HBM, supostamente, irão trazer salto considerável em largura de banda sobre as HBM3. As memórias HBM4, em desenvolvimento pela Samsung e SK Hynix, contariam com 2000 portas I/O e duas vezes a largura de banda atual, potencialmente revolucionando a computação de alto desempenho (HPC) e as GPUs para Inteligência Artificial.

- Afinal, o que é inteligência artificial?

- Computação de alto desempenho: essencial na vida diária e o futuro da tecnologia

Apesar de ainda não haver confirmação oficial por parte da Samsung, a informação foi divulgada no Seoul Economy e teria vindo de fontes seguras. Atualmente, as memórias HBM3 integradas a chips de IA já têm potencial para alcançar até 5 TB/s de banda.

Como lidar com isso tudo

Mesmo nas Nvidia H100, capazes de altíssimas cargas de trabalho, existe um limite de quantas instruções e inferências o chip consegue processar. Por essa razão, mesmo com as HBM3, as especificações técnicas da própria Nvidia definem a largura de banda atual em 3 TB/s.

Com isso, nas atuais configurações já é difícil saturar os canais de comunicação entre memórias e GPUs. Desa forma, elevar ainda mais esse potencial não deve fazer diferença significativa imediatamente, mas abre margem para escalar bruscamente a carga de trabalho em arquiteturas futuras, sem que a velocidade e vias de comunicação sejam gargalos.

A Nvidia já está trabalhando nas novas GPUs Blackwell G100, para IA, supostamente com dies modulares. Adotar essa nova arquitetura de processador é, justamente, um fator importante para garantir melhor aproveitamento das especificações do hardware.

Além de otimizar o espaço do die na PCB, fica mais fácil implementar novas tecnologias embarcadas, como aceleradores IA especializados. Até o momento o esperado é que as GPUs Nvidia G100 ainda utilizem memórias HBM3, possivelmente saturando seu potencial, mas com o salto de escalabilidade esperado, é provável que soluções com as HBM4 não demorem para surgir no mercado.

Fonte: DigiTimes

Trending no Canaltech:

- Entenda a trend do Império Romano que se espalhou pelas redes sociais

- Bard agora vasculha Gmail, YouTube, Drive e outros apps do Google

- Como é a técnica ancestral da China que substitui o ar-condicionado

- 😱 OFERTA ÚNICA | Galaxy S22 Ultra atinge preço excepcional para estudantes

- Concorrente do Twitter, Bluesky chega a 1 milhão de usuários

- Uber lança assinatura com cashback, frete grátis e recompensa por atraso

-vb41eeggsuaq.jpg)