Soluções Nvidia GH200 e H100 lideram benchmarks de inferência MLPerf

Superchip Nvidia GH200 Grace Hopper para aplicações de IA e HPC tem até 4x o desempenho das H100 em benchmark de inferência MLPerf

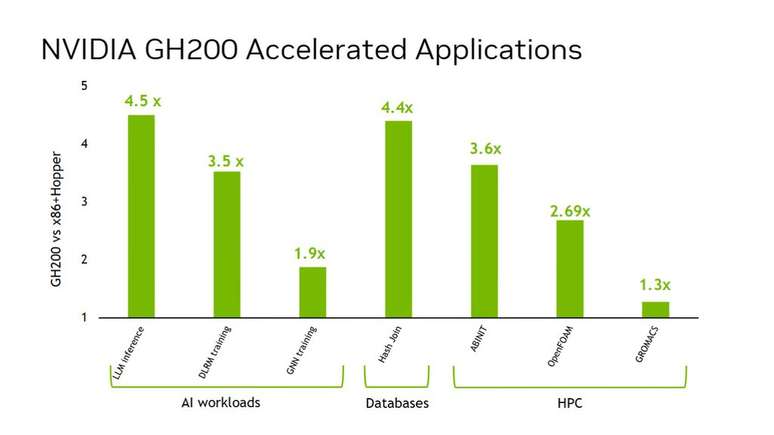

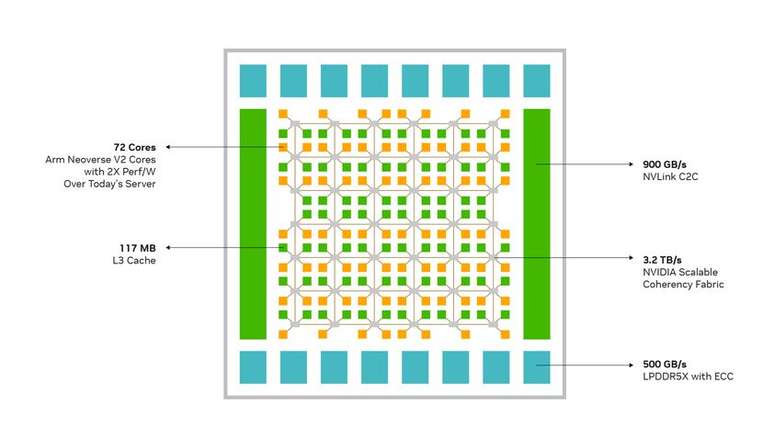

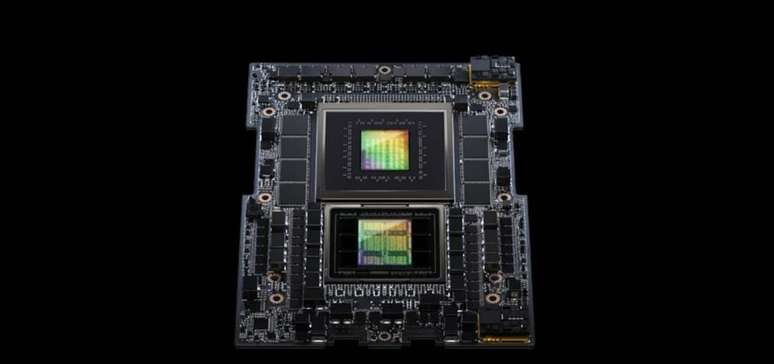

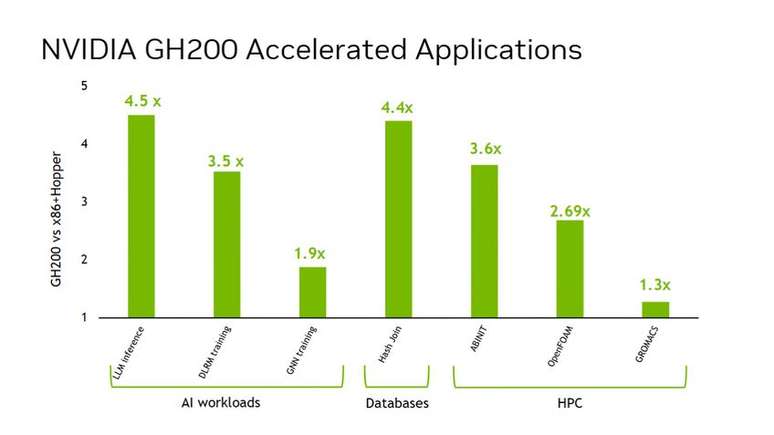

O superchip Nvidia Grace Hopper lidera o ranking nos benchmarks MLPerf de inferência, entregando até 4,5 vezes o desempenho de sistemas com CPUs x86 convencionais e GPUs H100. As GH200 combinam GPUs Hopper (H100), com CPUs Nvidia Grace (ARM), em uma plataforma desenvolvida sob medida para aplicações de IA, HPC e computação de borda.

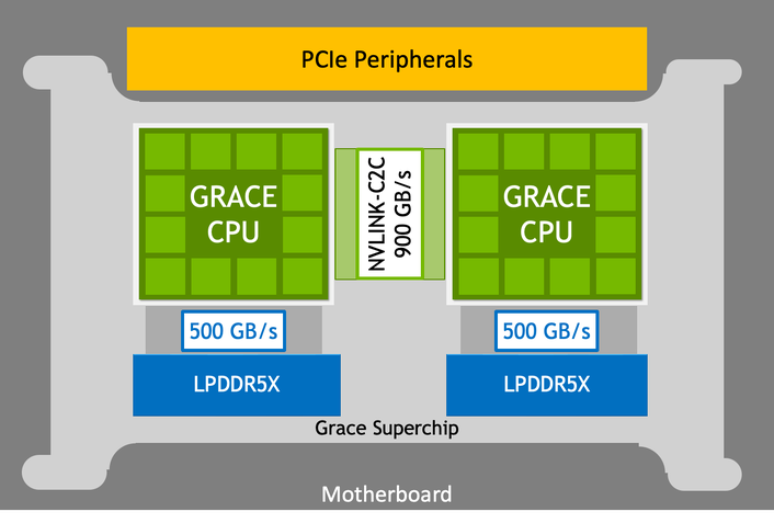

O projeto utiliza a tecnologia Nvidia NVLink-C2C para unir GPU e CPU em um único superchip. Isso garante ao sistema como um todo uma maior largura de banda, mais memória e capacidade de alternar entrega de energia automaticamente conforme a demanda.

Líder de mercado em aplicações de IA

As soluções Nvidia Grace Hopper e H100 lideram praticamente sem concorrência os testes de visão computacional, reconhecimento de fala e grande modelos de imagem (LLMs) de IA generativa. Ainda assim, a empresa continua a investir em ampliar sua vantagem.

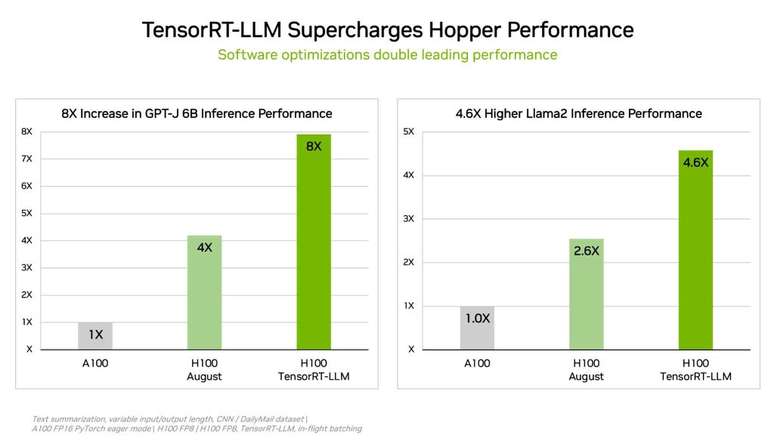

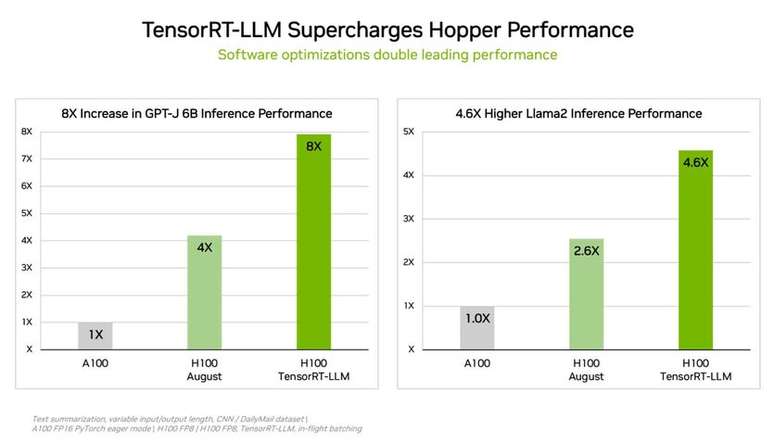

Em paralelo com as GH200, a Nvidia ainda desenvolveu o TensorRT-LLM, software de IA generativa com foco em otimizar o volume de inferências. A biblioteca de código aberto consegue dobrar o desempenho de inferência das GPUs H100, garantindo um enorme incremento sem a necessidade de upgrade para sistemas que já contam com as GPUs Nvidia.

O TensorRT-LLM elimina cargas de trabalho complexas com até duas vezes mais eficiência. Segundo testes internos, a aceleração de desempenho em relação à geração anterior, A100, em GPT-J 6B é de quatro vezes sem o novo software e salta para oito vezes com o TensorRT-LLM.

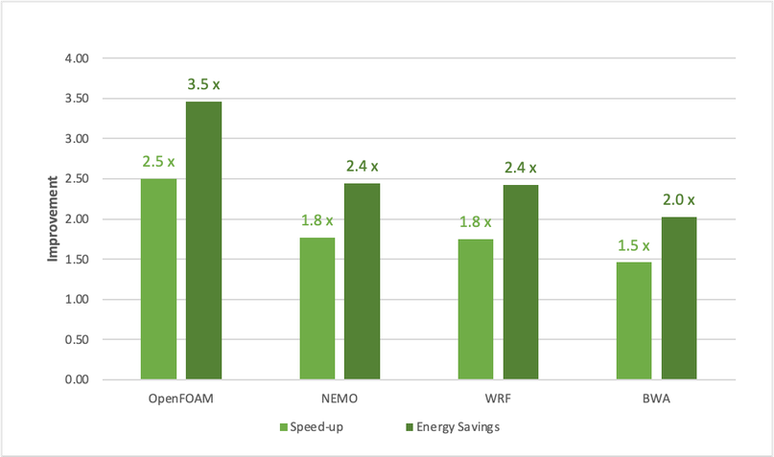

Isso também resulta em maior eficiência energética, reduzindo o custo total de operação e custos de energia em 5,3 e 5,6 vezes, respectivamente.

Trending no Canaltech:

- Google tem enigma que libera faixas de novo álbum de Taylor Swift

- Entenda a trend do Império Romano que se espalhou pelas redes sociais

- Concorrente do Twitter, Bluesky chega a 1 milhão de usuários

- Cratera de impacto é encontrada no topo de montanha na China

- IA generativa Adobe Firefly é lançada para todos

- Primeiro salmão vegano impresso em 3D chega aos supermercados europeus

-1hb85r9tvwbhx.jpeg)

-1h7r0b9m1psgz.png)